Stammdaten, die kritische Geschäftsobjekte wie Produkte, Lieferanten, Kunden oder Mitarbeiter des Unternehmens bezeichnen, sind für Unternehmen ein wertvolles Gut. Ohne kontinuierliche Maßnahmen zur Überprüfung und Verbesserung der Daten, nimmt jedoch die Datenqualität im Laufe der Zeit ab. Insbesondere bei der Datenmigration im Rahmen einer ERP-Einführung sollten Unternehmen möglichst früh mit der Überprüfung und Verbesserung des Datenbestandes beginnen.

Datenqualität bei der ERP-Einführung: Tippfehler bei der manuellen Dateneingabe, Fehler bei automatisierten Datenimports, Dubletten oder veraltete Daten – es gibt viele Fehlerquellen, die den Wert des Datenbestandes eines Unternehmens mindern. Mögliche Folgen sind u. a. erheblicher Zusatzaufwand, z. B. bei der Suche nach richtigen Werten, ein Akzeptanzverlust auf Kunden- und Mitarbeiterseite, ungenutzte Cross-Selling-Gelegenheiten oder falsche Tarif- und Preiskalkulationen.

In den meisten Fällen weiß die Unternehmensführung um die unzulängliche Qualität der Daten, stößt aber aus den folgenden Gründen keine entsprechenden Prozesse an:

1. Die durch schlechte Datenqualität entstehenden Nachteile sind nicht quantifizierbar.

In der Regel sind es die Mitarbeiter der Fachabteilung, die von den Folgen schlechter Datenqualität betroffen sind. Durch entsprechenden Zusatzaufwand (wie zusätzliche Abstimmungen und Rückfragen) müssen sie versuchen, die negativen Auswirkungen auf die Geschäftsprozesse auszugleichen und dabei bei Bedarf auch die Hilfe der IT-Abteilung in Anspruch nehmen. Nicht selten trauen die Mitarbeiter den im System abgelegten Daten nicht und legen deshalb lieber eigene Datenbestände (z. B. in Excel) an, weil sie diese auch ohne IT-Unterstützung bearbeiten können („Schatten-IT“). Geschäftsregeln (z. B. „Jeder Lieferant besitzt ein Sicherheitskennzeichen.“) existieren häufig nur in den Köpfen der Mitarbeiter und müssen beim Umgang mit den Unternehmensdaten explizit (ohne EDV-Systemunterstützung) berücksichtigt werden. Der wirtschaftliche Schaden dieser Missstände in den Daten kann schwer gemessen oder monetär bewertet werden.

Anzeige | kostenfreies Webinar der Trovarit Academy

|

|

A

|

Erfolgreiche Datenmigration: Tipps und Tricks für ein reibungsloses Verfahren

|

11.07.2025 |

| Thema: | Datenmigration, Datenmanagement |

| Referent: | Alex Ron, Trovarit AG |

2. Die Probleme werden von der Unternehmensführung nur unvollständig wahrgenommen.

Eine schlechte Datenqualität führt nicht unmittelbar zum Stillstand des Unternehmens. Wie bei einer verschmutzten Windschutzscheibe kann man dann zwar noch weiterfahren; doch die Frage ist, wann die nächste scharfe Kurve kommt. Die Unternehmensführung wird zwar hin und wieder Klagen der Mitarbeiter vernehmen, doch da die Mitarbeiter in der Regel nur vereinzelt Symptome der Auswirkungen der schlechten Datenqualität beschreiben können und es i. d. R. keine zentrale Instanz für die Aufnahme und Verarbeitung der Problemmeldungen gibt, wird das Ausmaß der Nachteile für die Unternehmensführung nicht greifbar. Das Lösen der Probleme erscheint für sie als nicht dringliche „Komfort-Maßnahme“ für die Mitarbeiter und erhält dadurch nur niedrige Priorität.

3. Der Aufwand zur Beseitigung der Probleme lässt sich für das Unternehmen nur schwer abschätzen.

Da sich auch die Kosten der mangelnden Datenqualität nicht unmittelbar beziffern lassen, ist eine Kosten-Nutzen-Analyse doppelt schwierig; es werden zunächst nur die Kosten gesehen, die die Maßnahmen zur Verbesserung der Datenqualität (z. B. Dublettenprüfung oder Standardisierung) verursachen (würden). Aufgrund der Schwierigkeit, den Aufwand und die Kosten dafür abzuschätzen, werden oft lieber keine Maßnahmen durchgeführt.

4. Es ist nicht klar, wie konkrete Schritte aussehen müssten.

Selbst wenn die Notwendigkeit einer Problemlösung erkannt wird, sind die durchzuführenden Maßnahmen nicht offensichtlich. Da sich die Probleme in den IT- und Fachabteilungen über mehrere Geschäftsbereiche hinweg manifestieren, gibt es im Unternehmen i. d. R niemanden, der den Gesamtüberblick hat und die Frage im Kern beantworten könnte.

Häufig werden verstärkte Aktivitäten im Bereich Stammdaten-Management erst angestoßen, wenn der Leidensdruck zu groß geworden ist und es zu kritischen Ineffizienzen in den Unternehmensabläufen kommt. Weitere Anlässe sind Fusionen und Restrukturierungen oder insbesondere auch die Einführung eines neuen ERP-Systems.

Doch auch wenn die Entscheidung für die Durchführung von Datenqualitätsmaßnahmen zur Vorbereitung einer bevorstehenden Migration und Systemeinführung gefallen ist, fehlt häufig eine passende Methodik zur Durchführung des Stammdatenprojekts und der Aufwand für die Projektdurchführung wird regelmäßig unterschätzt. Die Verantwortlichkeit für das Thema wird dann oft an die IT-Abteilung abgeschoben, die jedoch mit der Aufgabe neben ihrem Alltagsgeschäft hoffnungslos überfordert ist. Ohne Einbezug der Fachabteilungen, die die Geschäftsprozesse und deren Anforderungen kennen, und ohne entsprechende Unterstützung der Unternehmensführung ist ein solches Vorgehen von vornherein zum Scheitern verurteilt. Sinnvolle Maßnahmen zur Steigerung der Datenqualität erfordern ein methodisches Vorgehen, entsprechende Fachkenntnisse und Software-Tools zur Unterstützung der Datenanalyse und Maßnahmenumsetzung.

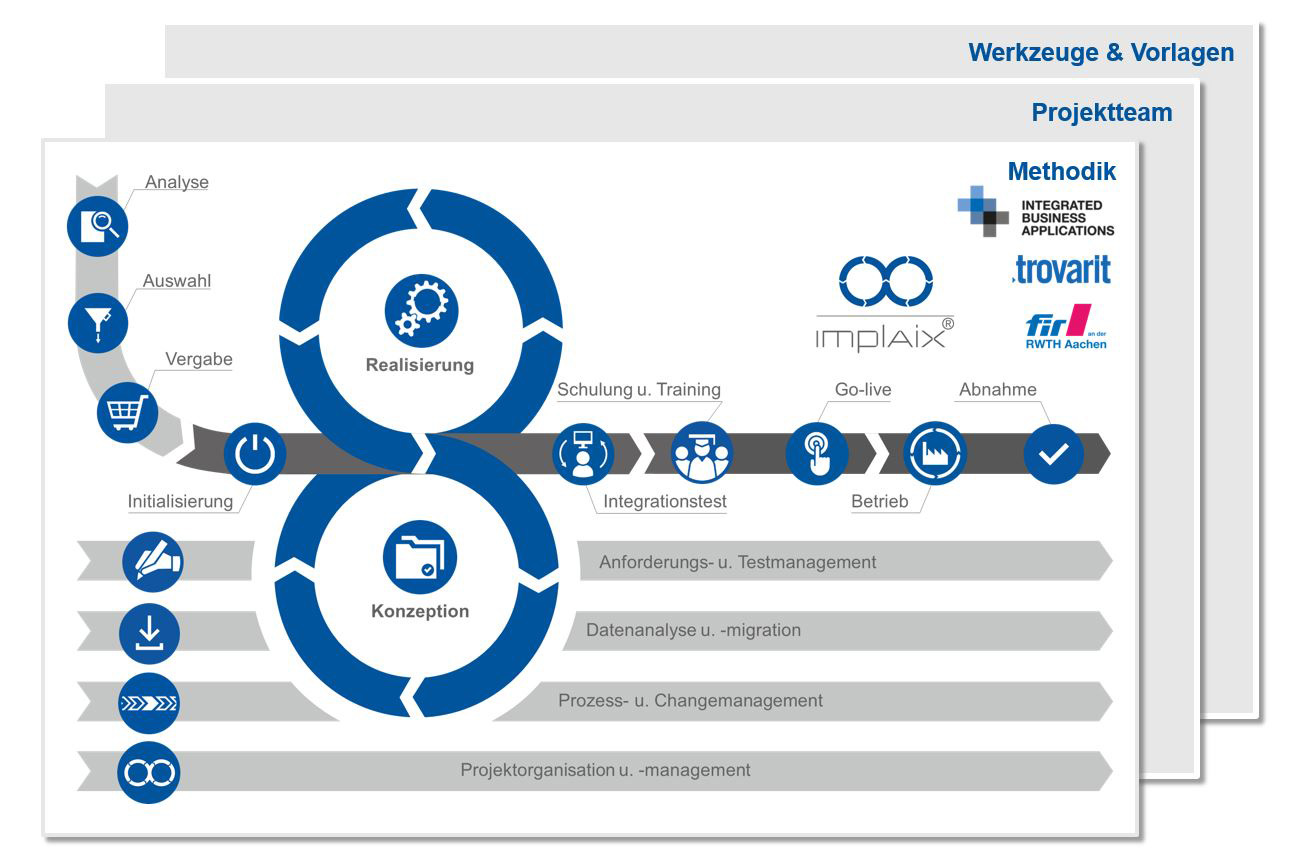

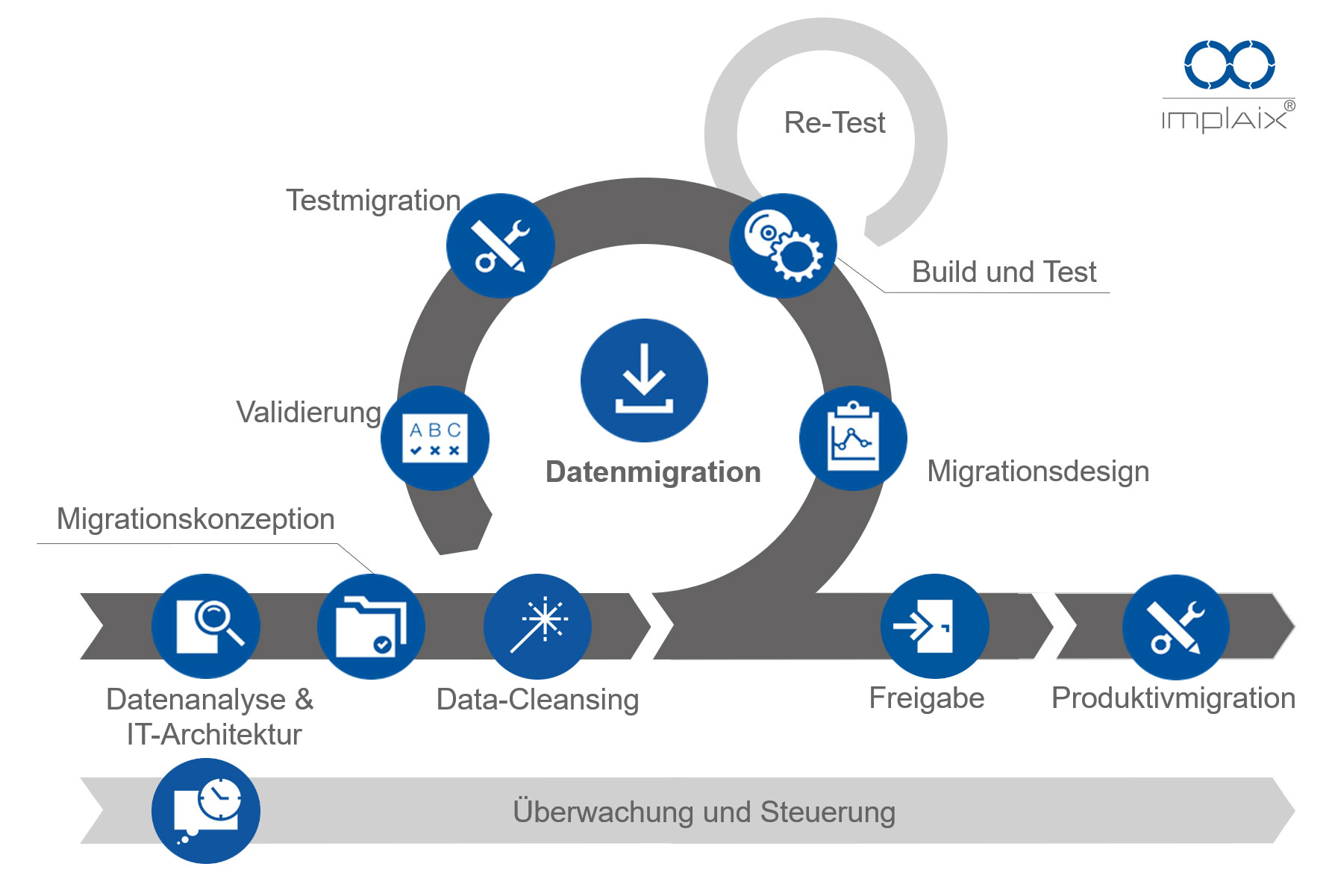

Hier setzt das Aachener Implementierungsmodell für Business Software (ImplAiX®) an. Die “Datenanalyse und -migration“ ist bei ImplAiX® eine Querschnittsaufgabe, welche parallel zu Konzeption, Realisierung etc. angeordnet ist. Gemäß der Empfehlung der Autoren des Modells sollte ein erstes grobes Konzept für die Datenübernahme schon im Rahmen der Leistungsspezifikation bei der Auftragsvergabe mit dem Dienstleister abgestimmt werden. Dieses bildet das Fundament für die weiteren Schritte der Datenmigration.

Die Datenqualität spielt aber auch nach der Datenmigration für die Akzeptanz des neuen Systems bei den Systemanwendern eine große Rolle. Denn die Ziele der Einführung eines neuen Systems sind u. a. Prozessoptimierung und -automatisierung sowie schnellerer Zugriff auf Informationen und Verbesserung der Informationsqualität. Wenn diese Erwartungen wegen mangelnder Datenqualität nicht erfüllt werden, wird die Unzufriedenheit eventuell auf das neue System projiziert. Die Konsequenz kann dann sein, dass das neue System von den Anwendern nicht akzeptiert bzw. dem neuen System nicht vertraut wird, sie (evtl. wie vor der Umstellung) neben dem System arbeiten und einen parallelen Datenbestand aufbauen, was wiederum zu einer weiteren Verschlechterung der Datenqualität führt.

Daher ist es auch nach der Migration wichtig, in einem repetitiven Prozess fortlaufend Datenanalysen und -bereinigungen durchzuführen, um die erreichte Datenqualität aufrechtzuerhalten und langfristig zu sichern. Denn selbst wenn bei entsprechender Maßnahmenumsetzung nach der Systemeinführung ein halbwegs akzeptabler Zustand erreicht wurde, kann die Datenqualität danach ohne regelmäßige Maßnahmen schnell wieder sinken. Unter Berücksichtigung von Kosten-Nutzen-Aspekten muss daher ein durchgehendes Stammdaten-Management in Kraft gesetzt werden, das wirksam ein erneutes Absinken der Qualität verhindert.