Das Training von neuronalen Netzen für Künstliche Intelligenz erfordert enorme Rechenressourcen und damit viel Strom. Eine neue Trainingsmethode funktioniert hundertmal schneller und damit wesentlich energieeffizienter. Die Qualität der Ergebnisse ist mit den bisherigen Verfahren vergleichbar.

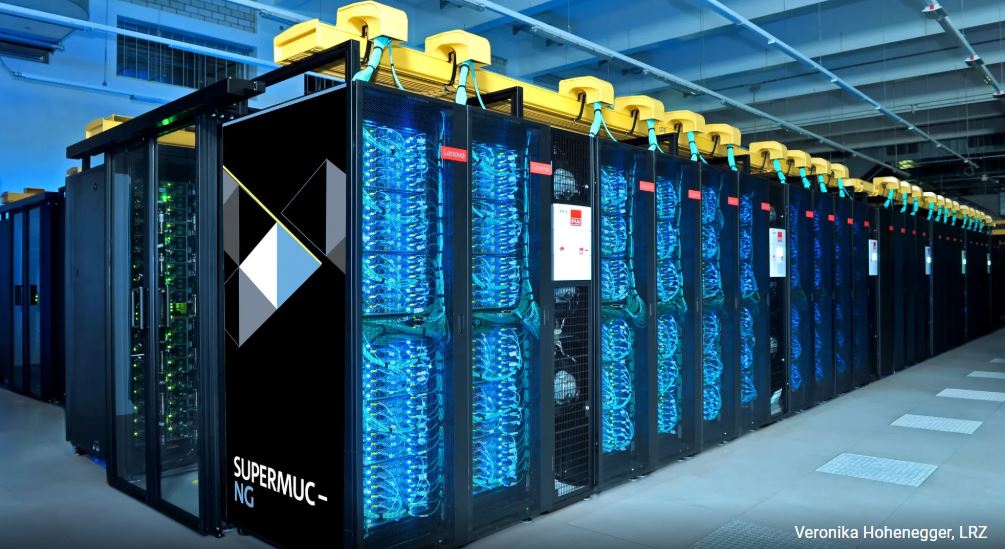

Nachhaltiges KI-Training mit hoher Effizienz: Anwendungen für Künstliche Intelligenz, wie beispielsweise Large Language Models, sind aus unserem Alltag kaum mehr wegzudenken. Rechenzentren stellen die dafür nötigen Speicher- und Verarbeitungskapazitäten zur Verfügung. Der Energieverbrauch ist enorm: 2020 lag er in Deutschland bei rund 16 Milliarden Kilowattstunden – etwa ein Prozent des gesamten deutschen Strombedarfs. Für das laufende Jahr prognostizieren Experten einen Anstieg auf 22 Milliarden Kilowattstunden.

Hundertfaches Tempo bei gleicher Genauigkeit

In den kommenden Jahren dürften komplexe Anwendungen die Anforderungen an Rechenzentren noch einmal deutlich erhöhen. Enorme Rechenressourcen beansprucht das Training von neuronalen Netzen. Um den Anstieg des Energieverbrauchs zu bremsen, haben Prof. Dr. Felix Dietrich, Professor für Physics-enhanced Machine Learning an der TU München, und sein Team eine Methode entwickelt, die hundertmal schneller ist und dabei vergleichbar genaue Ergebnisse liefert wie bisherige Trainingsvarianten. Damit sinkt der benötigte Strombedarf für das Training erheblich.

Der Kniff dabei: Statt die Parameter zwischen den Knotenpunkten wie bisher iterativ zu bestimmen, basiert der neue Ansatz auf Wahrscheinlichkeitsberechnungen. Die probabilistische Methode nutzt gezielt Werte, die sich an kritischen Stellen der Trainingsdaten befinden. Sie fokussiert sich also auf die Stellen, an denen sich die Werte besonders stark und schnell ändern. Sie zielt darauf ab, energieerhaltende dynamische Systeme aus Daten zu lernen. Solche Systeme verändern sich im Laufe der Zeit nach bestimmten Regeln und finden sich unter anderem in Klimamodellen oder auf dem Finanzmarkt.

Nachhaltiges KI-Training mit hoher Effizienz: Minimaler Rechenaufwand bei deutlich reduziertem Energieverbrauch

„Unsere Methode ermöglicht es, die benötigten Parameter mit minimalem Rechenaufwand zu bestimmen. Dadurch können neuronale Netze erheblich schneller und dadurch energieeffizienter trainiert werden“, erklärt Felix Dietrich. „Darüber hinaus hat sich gezeigt, dass die neue Methode in ihrer Genauigkeit mit iterativ trainierten Netzwerken vergleichbar ist.“

Neuronale Netze, die in der Künstlichen Intelligenz für Bilderkennung oder Sprachverarbeitung zum Einsatz kommen, sind in ihrer Funktionsweise durch das menschliche Gehirn inspiriert. Sie bestehen aus miteinander verknüpften Knoten, den sogenannten künstlichen Neuronen. Diese erhalten Eingabesignale, die dann mit bestimmten Parametern gewichtet und aufsummiert werden. Wird ein festgelegter Schwellenwert überschritten, erhalten die darauf folgenden Knoten das Signal. Zum Training des Netzwerks wurden die Parameter bisher zunächst zufällig in einer Normalverteilung gewählt. Im nächsten Schritt wurden sie über kleinste Änderungen angepasst, um die Netzwerkvorhersagen zu verbessern. Da diese Trainingsmethode viele Wiederholungen benötigt, ist sie extrem aufwändig und verbraucht viel Strom. Jürgen Frisch

Anzeige | Fachartikel „Künstliche Intelligenz & Business Software“

|

|||||||||||||||